写在前面

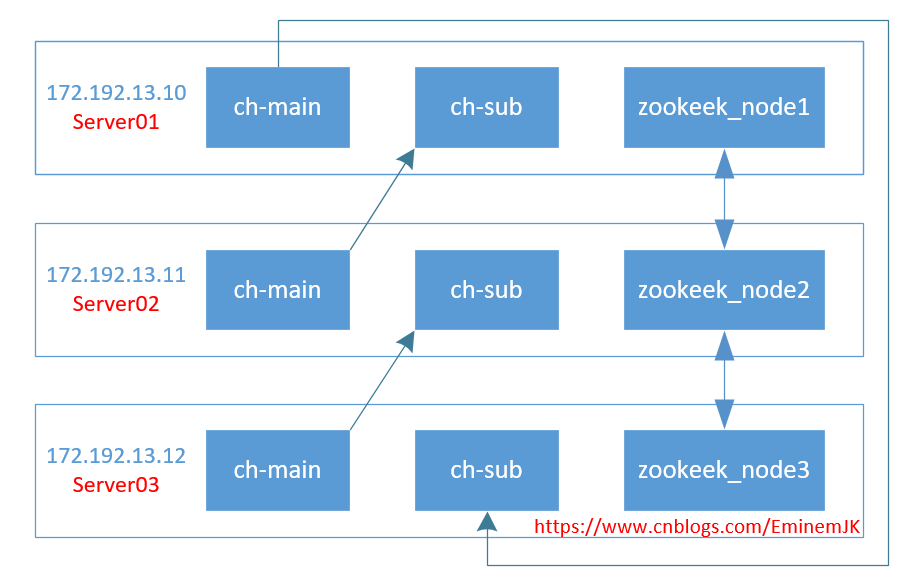

抽空来更新一下大数据的玩意儿了,起初架构选型的时候有考虑hadoop那一套做数仓,但是hadoop要求的服务器数量有点高,集群至少6台或以上,所以选择了clickhouse(后面简称ch)。ch做集群的话,3台服务器起步就可以的,当然,不是硬性,取决于你的zookeeper做不做集群,其次ch性能更强大,对于量不是非常巨大的场景来说,单机已经足够应对olap多种场景了。

进入正题,相关环境:

| ip | 服务器名 | 操作系统 | 服务 | 备注 |

| 172.192.13.10 | server01 | ubuntu20.04 | 两个clickhouse实例、zookeeper |

ch实例1端口:tcp 9000, http 8123, 同步端口9009,mysql 9004, 类型: 主分片1 ch实例2端口:tcp 9000, http 8124, 同步端口9010,mysql 9005, 类型: server02的副本 |

| 172.192.13.11 | server02 | ubuntu20.04 | 两个clickhouse实例、zookeeper |

ch实例3端口:tcp 9000, http 8123, 同步端口9009,mysql 9004, 类型: 主分片2 ch实例4端口:tcp 9000, http 8124, 同步端口9010,mysql 9005, 类型: server03的副本 |

| 172.192.13.12 | server03 | ubuntu20.04 | 两个clickhouse实例、zookeeper |

ch实例5端口:tcp 9000, http 8123, 同步端口9009,mysql 9004, 类型: 主分片3 ch实例6端口:tcp 9000, http 8124, 同步端口9010,mysql 9005, 类型: server01的副本 |

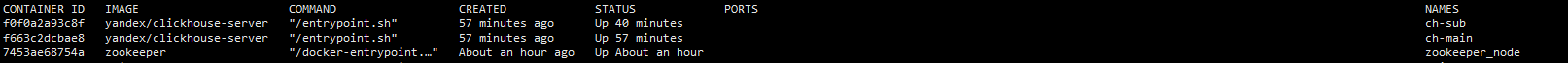

在每一台服务上都安装docker,docker里面分别安装有3个服务:ch-main,ch-sub,zookeeper_node,如图所示:

细心的已经看到,ports没有映射关系,这里是使用docker host网络模式,模式简单并且性能高,避免了很多容器间或跨服务器的通信问题,这个踩了很久。

环境部署

1. 服务器环境配置

在每一台服务器上执行:vim /etc/hosts,打开hosts之后新增配置:

|

1

2

3 |

172.192.13.10 server01

172.192.13.11 server02

172.192.13.12 server03 |

2.安装docker

太简单,略…

3.拉取clickhouse、zookeeper镜像

太简单,略…

zookeeper集群部署

在每个服务器上你想存放的位置,新建一个文件夹来存放zk的配置信息,这里是/usr/soft/zookeeper/,在每个服务器上依次运行以下启动命令:

server01执行:

|

1

2

3

4

5

6

7 |

docker run -d -p 2181:2181 -p 2888:2888 -p 3888:3888 --name zookeeper_node --restart always \\

-v /usr/soft/zookeeper/data:/data \\

-v /usr/soft/zookeeper/datalog:/datalog \\

-v /usr/soft/zookeeper/logs:/logs \\

-v /usr/soft/zookeeper/conf:/conf \\

--network host \\

-e zoo_my_id=1 zookeeper |

server02执行:

|

1

2

3

4

5

6

7 |

docker run -d -p 2181:2181 -p 2888:2888 -p 3888:3888 --name zookeeper_node --restart always \\

-v /usr/soft/zookeeper/data:/data \\

-v /usr/soft/zookeeper/datalog:/datalog \\

-v /usr/soft/zookeeper/logs:/logs \\

-v /usr/soft/zookeeper/conf:/conf \\

--network host \\

-e zoo_my_id=2 zookeeper |

server03执行:

|

1

2

3

4

5

6

7 |

docker run -d -p 2181:2181 -p 2888:2888 -p 3888:3888 --name zookeeper_node --restart always \\

-v /usr/soft/zookeeper/data:/data \\

-v /usr/soft/zookeeper/datalog:/datalog \\

-v /usr/soft/zookeeper/logs:/logs \\

-v /usr/soft/zookeeper/conf:/conf \\

--network host \\

-e zoo_my_id=3 zookeeper |

唯一的差别是:-e zoo_my_id=*而已。

其次,每台服务上打开/usr/soft/zookeeper/conf路径,找到zoo.cfg配置文件,修改为:

|

1

2

3

4

5

6

7

8

9

10

11

12

13 |

datadir=/data

datalogdir=/datalog

ticktime=2000

initlimit=5

synclimit=2

clientport=2181

autopurge.snapretaincount=3

autopurge.purgeinterval=0

maxclientcnxns=60

server.1=172.192.13.10:2888:3888

server.2=172.192.13.11:2888:3888

server.3=172.192.13.12:2888:3888 |

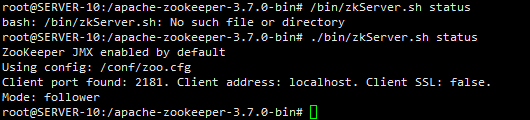

然后进入其中一台服务器,进入zk查看是否配置启动成功:

|

1

2

3 |

docker exec -it zookeeper_node /bin/bash

./bin/zkserver.sh status |

clickhouse集群部署

1.临时镜像拷贝出配置

运行一个临时容器,目的是为了将配置、数据、日志等信息存储到宿主机上:

|

1 |

docker run --rm -d --name=temp-ch yandex/clickhouse-server |

拷贝容器内的文件:

|

1

2

3 |

docker cp temp-ch:/etc/clickhouse-server/ /etc/

//https://www.cnblogs.com/eminemjk/p/15138536.html |

2.修改config.xml配置

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17 |

//同时兼容ipv6,一劳永逸

<listen_host>0.0.0.0</listen_host>

//设置时区

<timezone>asia/shanghai</timezone>

//删除原节点<remote_servers>的测试信息

<remote_servers incl="clickhouse_remote_servers" />

//新增,和上面的remote_servers 节点同级

<include_from>/etc/clickhouse-server/metrika.xml</include_from>

//新增,和上面的remote_servers 节点同级

<zookeeper incl="zookeeper-servers" optional="true" />

//新增,和上面的remote_servers 节点同级

<macros incl="macros" optional="true" /> |

其他listen_host仅保留一项即可,其他listen_host则注释掉。

3.拷贝到其他文件夹

|

1

2 |

cp -rf /etc/clickhouse-server/ /usr/soft/clickhouse-server/main

cp -rf /etc/clickhouse-server/ /usr/soft/clickhouse-server/sub |

main为主分片,sub为副本。

4.分发到其他服务器

|

1

2

3

4

5

6 |

#拷贝配置到server02上

scp /usr/soft/clickhouse-server/main/ server02:/usr/soft/clickhouse-server/main/

scp /usr/soft/clickhouse-server/sub/ server02:/usr/soft/clickhouse-server/sub/

#拷贝配置到server03上

scp /usr/soft/clickhouse-server/main/ server03:/usr/soft/clickhouse-server/main/

scp /usr/soft/clickhouse-server/sub/ server03:/usr/soft/clickhouse-server/sub/ |

scp真香。

然后就可以删除掉临时容器:docker rm -f temp-ch

配置集群

这里三台服务器,每台服务器起2个ch实例,环状相互备份,达到高可用的目的,资源充裕的情况下,可以将副本sub实例完全独立出来,修改配置即可,这个又是clickhouse的好处之一,横向扩展非常方便。

1.修改配置

进入server1服务器,/usr/soft/clickhouse-server/sub/conf修改config.xml文件,主要修改内容:

|

1

2

3

4

5

6

7

8

9

10

11 |

原:

<http_port>8123</http_port>

<tcp_port>9000</tcp_port>

<mysql_port>9004</mysql_port>

<interserver_http_port>9009</interserver_http_port>

修改为:

<http_port>8124</http_port>

<tcp_port>9001</tcp_port>

<mysql_port>9005</mysql_port>

<interserver_http_port>9010</interserver_http_port> |

修改的目的目的是为了和主分片main的配置区分开来,端口不能同时应用于两个程序。server02和server03如此修改或scp命令进行分发。

2.新增集群配置文件metrika.xml

server01,main主分片配置:

进入/usr/soft/clickhouse-server/main/conf文件夹内,新增metrika.xml文件(文件编码:utf-8)。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90 |

<yandex>

<!-- ch集群配置,所有服务器都一样 -->

<clickhouse_remote_servers>

<cluster_3s_1r>

<!-- 数据分片1 -->

<shard>

<internal_replication>true</internal_replication>

<replica>

<host>server01</host>

<port>9000</port>

<user>default</user>

<password></password>

</replica>

<replica>

<host>server03</host>

<port>9001</port>

<user>default</user>

<password></password>

</replica>

</shard>

<!-- 数据分片2 -->

<shard>

<internal_replication>true</internal_replication>

<replica>

<host>server02</host>

<port>9000</port>

<user>default</user>

<password></password>

</replica>

<replica>

<host>server01</host>

<port>9001</port>

<user>default</user>

<password></password>

</replica>

</shard>

<!-- 数据分片3 -->

<shard>

<internal_replication>true</internal_replication>

<replica>

<host>server03</host>

<port>9000</port>

<user>default</user>

<password></password>

</replica>

<replica>

<host>server02</host>

<port>9001</port>

<user>default</user>

<password></password>

</replica>

</shard>

</cluster_3s_1r>

</clickhouse_remote_servers>

<!-- zookeeper_servers所有实例配置都一样 -->

<zookeeper-servers>

<node index="1">

<host>172.16.13.10</host>

<port>2181</port>

</node>

<node index="2">

<host>172.16.13.11</host>

<port>2181</port>

</node>

<node index="3">

<host>172.16.13.12</host>

<port>2181</port>

</node>

</zookeeper-servers>

<!-- marcos每个实例配置不一样 -->

<macros>

<layer>01</layer>

<shard>01</shard>

<replica>cluster01-01-1</replica>

</macros>

<networks>

<ip>::/0</ip>

</networks>

<!-- 数据压缩算法 -->

<clickhouse_compression>

<case>

<min_part_size>10000000000</min_part_size>

<min_part_size_ratio>0.01</min_part_size_ratio>

<method>lz4</method>

</case>

</clickhouse_compression>

</yandex> |

<macros>节点每个服务器每个实例不同,其他节点配置一样即可,下面仅列举<macros>节点差异的配置。

server01,sub副本配置:

|

1

2

3

4

5 |

<macros>

<layer>01</layer>

<shard>02</shard>

<replica>cluster01-02-2</replica>

</macros> |

server02,main主分片配置:

|

1

2

3

4

5 |

<macros>

<layer>01</layer>

<shard>02</shard>

<replica>cluster01-02-1</replica>

</macros> |

server02,sub副本配置:

|

1

2

3

4

5 |

<macros>

<layer>01</layer>

<shard>03</shard>

<replica>cluster01-03-2</replica>

</macros> |

server03,main主分片配置:

|

1

2

3

4

5 |

<macros>

<layer>01</layer>

<shard>03</shard>

<replica>cluster01-03-1</replica>

</macros> |

server03,sub副本配置:

|

1

2

3

4

5 |

<macros>

<layer>01</layer>

<shard>02</shard>

<replica>cluster01-01-2</replica>

</macros> |

至此,已经完成全部配置,其他的比如密码等配置,可以按需增加。

集群运行及测试

在每一台服务器上依次运行实例,zookeeper前面已经提前运行,没有则需先运行zk集群。

运行main实例:

|

1

2

3

4

5

6

7

8 |

docker run -d --name=ch-main -p 8123:8123 -p 9000:9000 -p 9009:9009 --ulimit nofile=262144:262144 \\-v /usr/soft/clickhouse-server/main/data:/var/lib/clickhouse:rw \\-v /usr/soft/clickhouse-server/main/conf:/etc/clickhouse-server:rw \\-v /usr/soft/clickhouse-server/main/log:/var/log/clickhouse-server:rw \\

--add-host server01:172.192.13.10 \\

--add-host server02:172.192.13.11 \\

--add-host server03:172.192.13.12 \\

--hostname server01 \\

--network host \\

--restart=always \\

yandex/clickhouse-server |

运行sub实例:

|

1

2

3

4

5

6

7

8

9

10

11 |

docker run -d --name=ch-sub -p 8124:8124 -p 9001:9001 -p 9010:9010 --ulimit nofile=262144:262144 \\

-v /usr/soft/clickhouse-server/sub/data:/var/lib/clickhouse:rw \\

-v /usr/soft/clickhouse-server/sub/conf:/etc/clickhouse-server:rw \\

-v /usr/soft/clickhouse-server/sub/log:/var/log/clickhouse-server:rw \\

--add-host server01:172.192.13.10 \\

--add-host server02:172.192.13.11 \\

--add-host server03:172.192.13.12 \\

--hostname server01 \\

--network host \\

--restart=always \\

yandex/clickhouse-server |

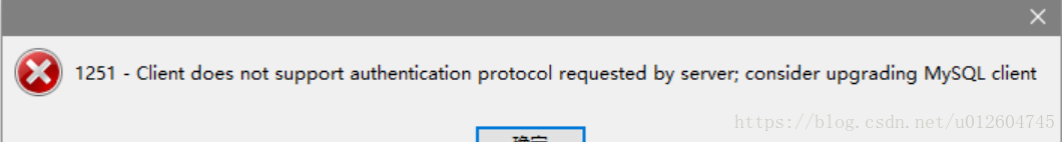

在每台服务器执行命令,唯一不同的参数是hostname,因为我们前面已经设置了hostname来指定服务器,否则在执行select * from system.clusters查询集群的时候,将is_local列全为0,则表示找不到本地服务,这是需要注意的地方。在每台服务器的实例都启动之后,这里使用正版datagrip来打开:

在任一实例上新建一个查询:

|

1

2

3

4

5

6

7

8

9

10 |

create table t_usertest on cluster cluster_3s_1r

(

ts datetime,

uid string,

biz string

)

engine = replicatedmergetree('/clickhouse/tables/{layer}-{shard}/t_usertest', '{replica}')

partition by toyyyymmdd(ts)

order by ts

settings index_granularity = 8192; |

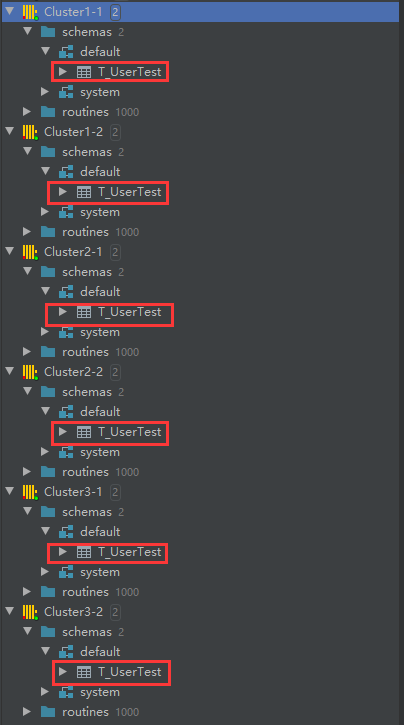

cluster_3s_1r是前面配置的集群名称,需一一对应上,/clickhouse/tables/是固定的前缀,相关语法可以查看官方文档了。

刷新每个实例,即可看到全部实例中都有这张t_usertest表,因为已经搭建zookeeper,很容易实现分布式ddl。

继续新建distributed分布式表:

|

1 |

create table t_usertest_all on cluster cluster_3s_1r as t_usertest engine = distributed(cluster_3s_1r, default, t_usertest, rand()) |

每个主分片分别插入相关信息:

|

1

2

3

4

5 |

--server01insert into t_usertest values ('2021-08-16 17:00:00',1,1)

--server02

insert into t_usertest values ('2021-08-16 17:00:00',2,1)

--server03

insert into t_usertest values ('2021-08-16 17:00:00',3,1) |

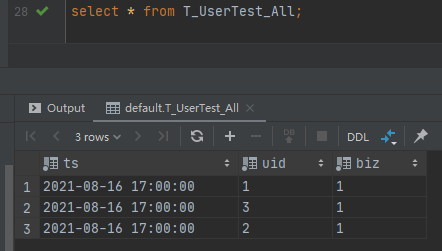

然后查询分布式表select * from t_usertest_all,

查询对应的副本表或者关闭其中一台服务器的docker实例,查询也是不受影响,时间关系不在测试。

到此这篇关于clickhouse docker集群配置及部署的文章就介绍到这了,更多相关clickhouse docker集群内容请搜索快网idc以前的文章或继续浏览下面的相关文章希望大家以后多多支持快网idc!

原文链接:https://www.cnblogs.com/EminemJK/p/15138536.html

相关文章

- 刀片服务器是什么 刀片服务器的主要特点 2025-05-27

- 利用FTP和计划任务自动备份网站数据和数据库 2025-05-27

- 服务器技术之硬件冗余技术 2025-05-27

- 服务器是租用还是服务器托管好? 2025-05-27

- 什么是DNS以及它如何影响服务器? 2025-05-27

- 2025-07-10 怎样使用阿里云的安全工具进行服务器漏洞扫描和修复?

- 2025-07-10 怎样使用命令行工具优化Linux云服务器的Ping性能?

- 2025-07-10 怎样使用Xshell连接华为云服务器,实现高效远程管理?

- 2025-07-10 怎样利用云服务器D盘搭建稳定、高效的网站托管环境?

- 2025-07-10 怎样使用阿里云的安全组功能来增强服务器防火墙的安全性?

快网idc优惠网

QQ交流群

-

2025-05-26 96

-

2025-05-26 118

-

2025-05-27 64

-

2025-05-26 78

-

2025-05-27 57