前言

我们在对英文句子分词的时候,一般采用采用的分词器是whitespacetokenizerfactory,有一次因业务要求,需要根据某一个特殊字符(以逗号分词,以竖线分词)分词。感觉这种需求可能与whitespacetokenizerfactory相像,于是自己根据solr源码自定义了分词策略。

业务场景

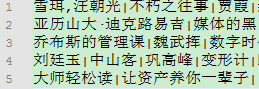

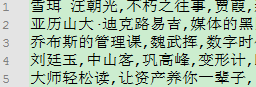

有一次,我拿到的数据都是以竖线“|”分隔,分词的时候,需要以竖线为分词单元。比如下面的这一堆数据:

有可能你拿到的是这样的数据,典型的例子就是来自csv文件的数据,格式和下面这种类似:

分词思路

在solr的schema.xml文件中,有这样的配置

|

1

2

3

4

5

|

<fieldtype name="text_ws" class="solr.textfield" positionincrementgap="100">

<analyzer>

<tokenizer class="solr.whitespacetokenizerfactory"/>

</analyzer>

</fieldtype>

|

对于字段类型text_ws,指定了一个分词器工厂whitespacetokenizerfactory,根据这个类,可以实现通过空格来分词,那么我通过竖线分词的代码应该与之类似。

修改源码

在java工程中引入如下jar包:

|

1

2

3

4

5

|

<dependency>

<groupid>org.apache.solr</groupid>

<artifactid>solr-core</artifactid>

<version>6.0.0</version>

</dependency>

|

参照whitespacetokenizerfactory的源码,写一个自己的myverticallinetokenizerfactory,内容基本不变:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

|

package com.trainning.project.custom;

import java.util.arrays;

import java.util.collection;

import java.util.map;

import org.apache.lucene.analysis.tokenizer;

import org.apache.lucene.analysis.core.unicodewhitespacetokenizer;

import org.apache.lucene.analysis.util.tokenizerfactory;

import org.apache.lucene.util.attributefactory;

/**

* @author jiangchao

* @date 2017年4月2日下午3:41:13

*/

public class myverticallinetokenizerfactory extends tokenizerfactory{

public static final string rule_java = "java";

public static final string rule_unicode = "unicode";

private static final collection<string> rule_names = arrays.aslist(rule_java, rule_unicode);

private final string rule;

/** creates a new myverticallinetokenizerfactory */

public myverticallinetokenizerfactory(map<string,string> args) {

super(args);

rule = get(args, "rule", rule_names, rule_java);

if (!args.isempty()) {

throw new illegalargumentexception("unknown parameters: " + args);

}

}

@override

public tokenizer create(attributefactory factory) {

switch (rule) {

case rule_java:

return new myverticallinetokenizer(factory);

case rule_unicode:

return new unicodewhitespacetokenizer(factory);

default:

throw new assertionerror();

}

}

}

|

具体做分词的myverticallinetokenizer代码如下

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

|

package com.trainning.project.custom;

import org.apache.lucene.analysis.util.chartokenizer;

import org.apache.lucene.util.attributefactory;

/**

* @author jiangchao

* @date 2017年4月2日下午9:46:18

*/

public class myverticallinetokenizer extends chartokenizer {

public myverticallinetokenizer() {

}

public myverticallinetokenizer(attributefactory factory) {

super(factory);

}

/** collects only characters which do not satisfy

* 参数c指的是term的ascii值,竖线的值为 124

*/

@override

protected boolean istokenchar(int c) {

return !(c == 124);

}

}

|

这里最主要的方法就是istokenchar,它控制了分词的字符,如果需要使用逗号分词的话,字需要将这个方法修改成下面这样:

|

1

2

3

4

5

6

7

|

/** collects only characters which do not satisfy

* 参数c指的是term的ascii值,逗号的值为 44

*/

@override

protected boolean istokenchar(int c) {

return !(c == 44);

}

|

整合

代码写好了,怎么使用呢?首先,需要把刚才的java文件打成jar包。我使用的是eclipse,直接选中两个类文件,右键 -> export -> jar file -> select the export destination: ->选择输出路径,填一个jar名字:myverticallinetokenizerfactory -> finish

得到的myverticallinetokenizerfactory.jar文件大约3kb,将改文件放置到.\\solr_home\\lib下,在shcema.xml中定义自己的field

|

1

2

3

4

5

6

|

<fieldtype name="vertical_text" class="solr.textfield">

<analyzer>

<tokenizer class="com.trainning.project.custom.myverticallinetokenizerfactory"/>

</analyzer>

</fieldtype>

<field name="custom" type="vertical_text" indexed="true" stored="false"/>

|

注意这里的class是刚才自己写的分词器的完整类名。

打开solr主页,在analysis页面测试一下,是否实现了预期?

源码下载:

github:下载地址

总结

以上就是这篇文章的全部内容了,希望本文的内容对大家的学习或者工作能带来一定的帮助,如果有疑问大家可以留言交流,谢谢大家对快网idc的支持。

原文链接:http://blog.csdn.net/jiangchao858/article/details/68954044

相关文章

- ASP.NET本地开发时常见的配置错误及解决方法? 2025-06-10

- ASP.NET自助建站系统的数据库备份与恢复操作指南 2025-06-10

- 个人网站服务器域名解析设置指南:从购买到绑定全流程 2025-06-10

- 个人网站搭建:如何挑选具有弹性扩展能力的服务器? 2025-06-10

- 个人服务器网站搭建:如何选择适合自己的建站程序或框架? 2025-06-10

- 2025-07-10 怎样使用阿里云的安全工具进行服务器漏洞扫描和修复?

- 2025-07-10 怎样使用命令行工具优化Linux云服务器的Ping性能?

- 2025-07-10 怎样使用Xshell连接华为云服务器,实现高效远程管理?

- 2025-07-10 怎样利用云服务器D盘搭建稳定、高效的网站托管环境?

- 2025-07-10 怎样使用阿里云的安全组功能来增强服务器防火墙的安全性?

快网idc优惠网

QQ交流群

-

2025-06-04 81

-

2025-06-04 22

-

2025-05-29 60

-

如何利用智能建站平台创建响应式设计,确保在各种设备上的良好显示?

2025-05-27 71 -

2025-05-29 23